Экспериментальная психология

2023. Том 16. № 2. С. 87–100

doi:10.17759/exppsy.2023160206

ISSN: 2072-7593 / 2311-7036 (online)

Экспериментальное сравнение доверия искусственному интеллекту и человеку в экономических решениях

Аннотация

Доверие искусственному интеллекту (ИИ) является особенно актуальным направлением в изучении взаимодействия «человек—компьютер» и требует нового взгляда на доверие как феномен. В нашем исследовании мы делаем акцент на изучении проявления доверия в контексте экономического поведения. Исследование проходило в два этапа. На первом этапе в ходе интервью были выявлены основные факторы доверия и недоверия ИИ, отдельно сформулированы факторы доверия ИИ в экономических решениях. Также был выявлен субъективный показатель уровня доверия советнику — экономическая активность участника при выполнении рекомендованного действия. На втором этапе был проведен эксперимент, где участникам предлагалось сыграть в симуляторе фондовой биржи. Целью игры было заработать денег на купле-продаже акций. В игре была опция обратиться к экономическому советнику. У экспериментальной группы в качестве советника выступал ИИ, у контрольной — человек (эксперт в трейдинге). По результатам анализа 800 экономических решений экономическая активность в ходе игры была выше у участников контрольной группы, которые следовали советам человека (t= 3,646; p<0,001). В результате проведенного исследования были получены три основных вывода: 1) уровень доверия советам в экономическом решении может быть выражен в виде экономической активности; 2) уровень доверия экономической рекомендации зависит от того, дает рекомендацию человек или ИИ; 3) выделяются специфические факторы доверия в экономическом решении: индивидуальность совета и скорость запрашиваемого решения.

Общая информация

Ключевые слова: доверие , искусственный интеллект, экономическое поведение, поддержка принятия решений

Рубрика издания: Психология цифровой реальности

Тип материала: научная статья

DOI: https://doi.org/10.17759/exppsy.2023160206

Получена: 10.12.2021

Принята в печать:

Для цитаты: Винокуров Ф.Н., Садовская Е.Д. Экспериментальное сравнение доверия искусственному интеллекту и человеку в экономических решениях // Экспериментальная психология. 2023. Том 16. № 2. С. 87–100. DOI: 10.17759/exppsy.2023160206

Полный текст

Введение

Технологии с применением искусственного интеллекта активно входят в рутину человека в 2023 году. Никого уже не удивить использованием ИИ в сферах транспорта, медицины и развлечений [Fridman, 2017; Longoni, 2019; Lucas, 2014; Wang, Dayong, et, 2016]. Взаимодействие человека с ИИ становится важным аспектом успешной деятельности, что усиливает интерес и среди психологов. Появляются работы, рассматривающие ИИ как социальных агентов [Castelfranchi, 1998], изучающие продуктивность совместной работы в зависимости от восприятия ИИ и опыта взаимодействия с ним [Ulfert, 2022; Yu, 2017]. Наша работа также связана с результатами совместной работы человека с ИИ, но не в трудовой деятельности, а в экономической. В эксперименте, описанном ниже, мы проверяем гипотезу об уровне доверия экономической рекомендации в зависимости от того, дана она человеком или программой на основе ИИ.

Доверие в социальной психологии

В социальной психологии доверие рассматривается в контексте межличностных отношений (например, в коммуникации — доверие носителю информации, доверие информации и др.) [Андреева, 2001].

Классической для отечественной социальной психологии является работа Т.П. Скрипкиной [Скрипкина, 2000], посвященная всестороннему анализу феномена доверия в социальной психологии. Для нас важно отметить, что глобально доверие может существовать в отношении себя, Мира или некого Другого. Привычным Другим в данном случае выступает человек (значимый или нет, в личном контексте или профессиональном и т. п.). Может ли в качестве Другого выступать ИИ?

В реальных условиях взаимодействие с ИИ может походить не только на взаимодействие с программой или роботом. В контексте, когда мы запрашиваем у ИИ помощь, разговариваем с голосовым помощником и др., мы можем имитировать межличностные отношения и строить социальный диалог [Bickmore, 2005]. А значит, взаимодействие с ИИ может отчасти рассматриваться и как взаимодействие с Другим, и как взаимодействие с частью Мира. Поэтому обратимся к примерам исследований доверия в обоих направлениях.

Говоря о доверии Другому, разные авторы немного по-разному подходят к определению доверия. Сафонов описывает доверие в межличностной коммуникации как обмен значимыми мыслями и чувствами на основе веры в партнера, при этом происходит определенное обособление этой пары общающихся людей от остальных [Сафонов, 1981]. Автор отмечает, что доверие заключается в отношении к партнеру как к человеку, который не станет использовать значимое раскрытие против доверившегося. То есть мы можем рассмотреть феномен доверия как некоторую установку, аттитюд, направленный на партнера, который имеет эмоциональный, когнитивный и поведенческий компоненты. Гозман [Гозман, 1987] выделяет в становлении доверия два этапа: определение безопасности и меры сходства с самим собой. Таким образом, здесь, как и у Сафонова, звучит идея безопасности партнера по взаимодействию, но добавляется элемент воспринимаемой схожести во взглядах.

Продолжая тему доверия Другому, но уже в русле отношения именно к технологии, Купрейченко была разработана методика на основе пяти симметричных шкал доверия/недоверия для оценки уровня доверия технологии: Надежность; Предсказуемость; Приязнь; Единство; Расчет [Купрейченко, 2012]. Эта методика составлена как реплика методик на определение доверия другому человеку, но адаптирована под использование в области технологии.

В то же время мы видим и исследования, направленные на изучение доверия технологии как части Мира. Например, исследования Нестика, Журавлева [Журавлев, 2019] и Солдатовой [Солдатова, 2016], которые направлены на выявление личностных характеристик, влияющих на формирование определенного уровня доверия технологиям в целом.

В нашем исследовании ИИ будет представлен интеллектуальным помощником (по аналогии с подобным помощником человеком), поэтому в рамках экспериментальной части исследования мы концентрируемся на понимании доверия к ИИ как доверия Другому.

Тем не менее, на первом этапе работы на качественном уровне мы попытались определить, к какой категории доверия отнести доверие ИИ в целом. На втором этапе мы экспериментально проверили различия в уровне доверия человеку и ИИ в условиях принятия экономических решений.

Операционализация основных понятий

Доверие

Мы рассматриваем доверие в качестве установки в межличностных отношениях, так как доверие проявляется к конкретному объекту доверия в ситуации взаимодействия (советнику в экономическом решении).

В случае экономической игры доверие советнику определяется через готовность рисковать собственным ресурсом, опираясь на рекомендацию советника. Соответственно, если действие участника совпадает с рекомендованным советником, то мы определяем это как доверие, проявленное в данный конкретный момент.

Степень этого доверия выражается в экономической активности. Она выражается в количестве ресурса (условных единиц), которыми участник игры готов рискнуть, в отношении к оставшемуся балансу игрока на данный момент.

Подобная операционализация стала возможна благодаря пилоту исследования и качественной части данной работы, описанной ниже.

Искусственный интеллект

В нашей экспериментальной работе ИИ представлен в виде ПО, обученного на данных о покупках/продажах акций. Его цель — предоставлять оптимальные рекомендации по следующему шагу игрока.

Гипотеза

Степень доверия экономической рекомендации зависит от того, дана эта рекомендация человеком или ИИ.

Материалы и методы

Исследование проходило в два этапа.

- В рамках первой части в целях выделения факторов и критериев доверия/недоверия искусственному интеллекту в роли советника при принятии решений были проведены шесть глубинных интервью. В результате данного этапа были определены специфика восприятия ИИ именно в экономических решениях и основные факторы доверия и недоверия ИИ.

- Во второй части исследования был проведен эксперимент с двумя группами. Выборка составила 40 человек (21 женщина и 19 мужчин). Основной задачей второго этапа исследования была проверка основной гипотезы — выявление наличия зависимости уровня доверия советнику в экономическом решении от того, является ли советник человеком или ИИ.

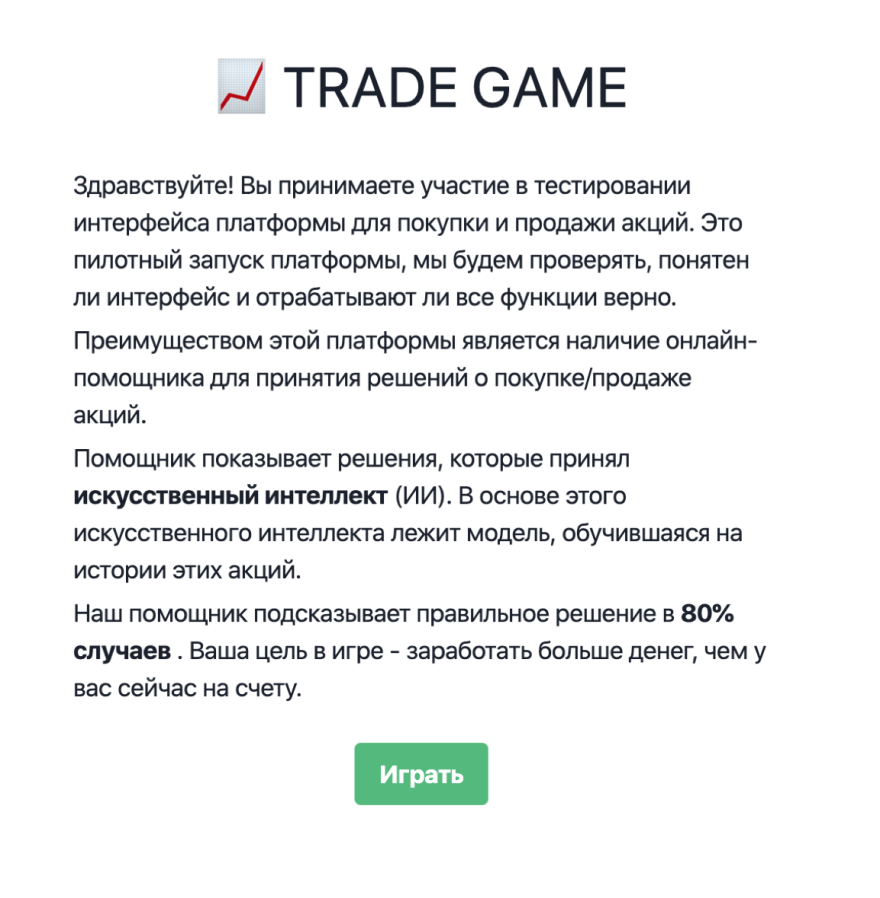

Описание экономической игры

Экономическая игра заключалась в принятии решения о купле-продаже акций. Для принятия решения участникам был представлен график акций по последним четырем шагам и текущая стоимость акций.

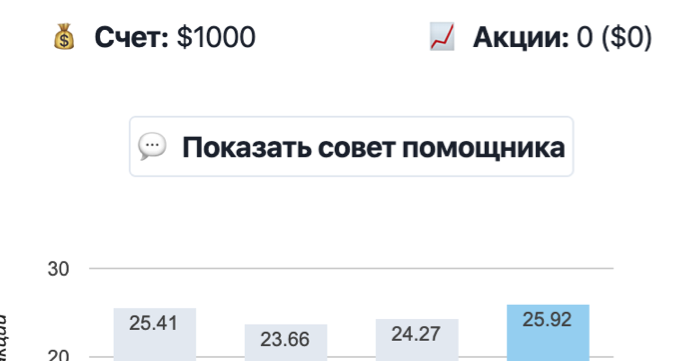

Целью в игре было увеличить свой бюджет за счет купли-продажи. На каждом ходу участники могли купить акции (исходя из своего текущего баланса), продать их (исходя из количества уже приобретенных акций) или пропустить ход. Участники могли воспользоваться подсказкой советника, нажав на соответствующее поле и увидев его рекомендацию. В игре были предусмотрены 2 тренировочных хода и 20 игровых ходов.

Перед сбором основных экспериментальных данных была проведена серия пилотов (2 пилота по 6 участников в каждом) с целью оценки понятности инструкций для участников и интерфейса экономической игры.

Пилот был проведен в формате выполнения задач игры и проговаривании мыслей участников вслух, благодаря этому были также собраны данные о ходе размышления и принятии экономического решения в ходе экономической игры.

В результате серии пилотов в игре были проведены изменения:

- количество шагов увеличено с 15 до 20, так как респонденты высказывали желание играть дольше, к 15 ходу они только «втягивались», появлялся азарт;

- в основной текст инструкции добавлена информация о подсчете выигрыша в последний ход, выделены жирным шрифтом информация о том, кто является советником и какой процент верных советов он дает на каждый шаг, так как к началу игры участники говорили, что уже не помнят, кто их помощник и какой процент вероятности его ошибки;

- четко сформулирована основная цель игры («заработать денег больше, чем есть сейчас на счету»);

- введены тренировочные ходы (чтобы познакомить с интерфейсом программы и основными функциями до начала сбора данных и отделить инструкцию с информацией о советнике, чтобы она не выглядела навязчивой и не слишком призывала к использованию помощника);

- принято решение исключить из основной выборки исследования участников с опытом купли-продажи акций и тех, чья профессиональная деятельность связана с ИИ.

В ходе основной части сбора данных второго этапа участники были случайным образом поделены на две группы: одной группе была представлена версия игры с советником в виде человека-эксперта (трейдера), второй группе была представлена версия игры с советником в виде искусственного интеллекта (ИИ). В остальном игры были абсолютно одинаковыми, в инструкции предусматривался одинаковый процент успеха предсказания советника (80%), объяснялся механизм, по которому советник предлагает решение (и в том и в другом случае советник изучил историю данной акции и предлагал решения, основанные на ней); сама игра строилась на динамике одной и той же акции, а советники выдавали одинаковые рекомендации (см. Рис. 1).

Далее участникам было предложено выполнить два тренировочных хода, чтобы подготовиться к началу игры: «Давайте потренируемся. Первые два хода не пойдут в общий зачет.

Перед вами график акции, сейчас вам нужно будет принять решение о покупке. Вы можете потратить любую сумму из внесенных средств, либо не тратить деньги вообще и пропустить ход.

Ваша цель в игре — заработать больше денег, чем у вас сейчас на счету.

Старайтесь действовать так, как действовали бы в реальной жизни и старайтесь произносить вслух все, что будет приходить вам в голову.

/ кнопка “тренироваться”/».

После тренировочных ходов начиналась непосредственно игра и выводилась следующая инструкция.

«Теперь перейдем к игре. Напоминаем, ваша цель — заработать больше денег, чем у вас сейчас на счету за 20 ходов.

/кнопка “начать игру”/».

В ходе самой игры участники могли при желании обратиться к подсказке онлайн-советника, нажав на кнопку «Показать совет помощника» (рис. 2).

По окончании игры демонстрировался результат игрока (рис. 3).

Рис. 3. Пример отображения окончания игры

Таким образом, в нашем эксперименте независимая переменная — описание онлайн-советника представлена на двух уровнях:

1) онлайн-советник является человеком (экспертом-трейдером);

2) онлайн-советник является ИИ (искусственным интеллектом).

Зависимая переменная — уровень экономической активности за ход.

Экономическая активность в нашем исследовании представлена в виде отношения суммы денег, используемых за данный ход (в случае продажи акций — суммарная стоимость этих акций, в случае покупки — потраченные деньги), к текущему балансу на данный ход (баланс складывается из свободных средств на счету испытуемого и денежного эквивалента акций, доступных для продажи).

Выборка

Всего в исследовании приняли участие 46 человек (3 мужчины и 3 женщины в рамках качественного этапа и 21 женщина и 19 мужчин в рамках эксперимента). Возраст участников варьировался от 20 до 40 лет).

Респонденты для обоих этапов были набраны на добровольной основе через социальную сеть Вконтакте по следующим критериям.

- Средний уровень знакомства с технологией искусственного интеллекта, т. е. работа/учеба/профессия участников не был связан с данной технологией, при этом присутствует общее знакомство с технологией. На этапе пилота исследования в общении с профессионалом в области ИИ было выявлено, что специалисты не готовы воспринимать информацию от советника-ИИ, если не указаны технические детали программы.

- Отсутствие опыта участия в биржевых сделках, сделках купли-продажи акций, так как на этапе пилота респонденты с опытом участия в сделках ожидали большей информации для принятия решения о купле-продаже и отказывались принимать участие в игре.

Результаты исследования

Первый этап (интервью)

На данном этапе для нас было важно определить, в каких категориях респонденты рассуждают об ИИ и существует ли такая категория понятий, как "доверие ИИ", из чего она состоит. Как видно из цитат ниже, категория доверия ИИ кажется всем респондентам знакомой темой, они развивают мысли на эту тему легко и приводят примеры.

С точки зрения основной гипотезы исследования в ходе интервью все участники могли назвать причины возможного доверия и недоверия технологии ИИ в качестве советника (по сравнению с советником-человеком). Купрейченко выделяет понятия доверия и не-доверия не как полюса одной шкалы, а как самодостаточные оценки [Купрейченко, 2008]. В рамках бесед с респондентами эта концепция так же воспроизводится, респонденты говорят о недоверии как о самостоятельной категории восприятия ИИ.

В разговоре о недоверии ИИ респондентами выделялись следующие основные причины недоверия этой технологии .

- Недостаточно знаний о технологии: «Здесь все-таки к человеку, есть какие-то показатели, конечно, на которые может ориентироваться ИИ... если попытаться объяснить... я просто не представляю, какую диагностику может проводить ИИ»;

- Технология ИИ может использоваться против человека или определенной группы:

«Есть опасения, что данные о моих ценностях, предпочтениях, которые можно как-то использовать в своих целях… как Кэмбридж-аналитика».

Похожие результаты также представлены в исследованиях Нестика, где одним из выводов было суждение о том, что внедрение технологий искусственного интеллекта будет обращать внимание граждан на случаи «несправедливости и дискриминации», так как использоваться они будут определенными институтами в целях снижения субъективного фактора, что в первое время только усилит этот разрыв между теми, кто имеет власть над технологией, и теми, на кого эта технология распространяется [Нестик, 2018].

- Зависимость от создателя ИИ: «Кто делает ИИ, тот и его создатель... Соответственно, ИИ становится заложником стереотипов своего создателя».

Подобный подход к доверию техническим системам описывает Купрейченко [Купрейченко, 2012], когда предлагает интерпретировать доверие системе через доверие ее создателю и человеку (людям), которые ей управляют.

Основная декларируемая причина как доверия, так и недоверия одновременно:

- Объективность, отсутствие предубеждений искусственного интеллекта: «ИИ ориентируется на индексы, а человек подвержен всяким предубеждениям»; «Мне кажется, акции это когда ты наверняка как раз не можешь ничего просчитать и здесь важнее накопленный опыт и интуиция что ли».

Среди сфер, в которых респонденты встречались с ИИ и не испытывали недоверие, — таргетинг (реклама, подбор музыки, подбор фильма), карты (пробки, построение оптимального маршрута), банки (анализ истории и расчет оптимального предложения), компьютерное зрение (замена фонов при видео звонках, перемещение людей и контроль границ), беспилотные автомобили: «Вот в Яндекс.Музыке, например, очень классные рекомендации, они прямо предугадывают, что мне понравится»; «Ну вот в банках, например, они могут проанализировать там мои доходы/расходы и сразу как бы предодобрить кредит какой-нибудь хороший, мне это нравится»; «Данные по кредитам там многих людей переносятся, создаются как бы типы клиентов, им предлагается что-то актуальное и полезное»; «Беспилотные автомобили иногда лучше, чем водители»; «Мое отношение в целом положительное, нежели отрицательное… Мне лично нравятся всякие подходы классификации и компьютерное зрение то что называется»; «Хорошо будет ИИ применять в плане контроля перемещения людей, как вот сейчас показал опыт карантина у Китая».

Поскольку в нашем исследовании мы делаем акцент именно на принятии решения с учетом рекомендации от ИИ, то принятие решений на основе данных от него обсуждалось отдельно. По словам респондентов, с одной стороны, искусственный интеллект позволяет человеку преодолеть преграды в объеме информации, которую можно обработать единовременно, тем самым увеличивает «вместимость» человека. С другой стороны, человеческая интуиция кажется зеркальной уникальной особенностью человека. Интуиция называется и некоторыми исследователями возможностью обработать больший объем информации за раз, учесть весь свой опыт, знания из смежных областей и др. [Jarrahi, 2018].

Говоря о критериях готовности обратиться за советом к ИИ, в ходе интервью мы обсуждали с респондентами специфические факторы доверия для сферы принятия экономических решений.

- Скорость принятия решения, если решение должно быть быстрым, то респонденты высказывали предположение о том, что в сравнении с человеком-экспертом, они предпочтут ИИ: «Вот когда нужно сделать что-то срочно быстро без разговоров, то тогда я готов обратиться к ИИ, а если это что-то долгосрочное... а если мне захочется еще об этом поговорить, то это к человеку” [сфера принятия экономических решений]; «В моем представлении ИИ быстрее думает и дальше видит».

Возможно, речь идет о том случае, когда вместимость (capacity) искусственного интеллекта с точки зрения информации за единицу времени выше, чем у человека, что и является одним из аргументов его использования в качестве помощника в принятии решений [Нестик, 2018; Marwala, 2014; Jarrahi, 2018].

- Индивидуальность совета: «Если все будут обращаться к ИИ, то это будет тоже влиять очень сильно, никто не будет получать профита... Акции не те будут расти, которые показывает ИИ» [сфера принятия экономических решений];

Отмечается влияние эксклюзивности доступа к технологии. Причем это звучит как обратная сторона критерия недоверия, когда респонденты высказывали опасения о том, что технология и управление ей доступно лишь ограниченному количеству людей.

Многие исследования искусственного интеллекта в принятии решений связаны с работой в связке с человеком, например, исследование, показавшее эффективность работы человека-медика в связке с искусственным интеллектом при выявлении рака при оценке изображений определенных клеток. Причем исследование продемонстрировало, что в связке человек-искусственный интеллект уровень точности выше, чем у каждого из них в отдельности; исследователи называют это синергетическим партнерством [Ulfert, 2022]. В то же время другие исследования в области создания систем поддержки принятия решения (decision-support systems DSS) показывают, как сильно зависит общий успех командной работы человека и ИИ от типа взаимодействия. Если задачи, выполняемые совместно, предполагают перепроверку друг друга, то общий успех снижается, если же каждый имеет свою зону экспертности, то успешность выполнения общей задачи становится выше [Zhang, 2022].

Таким образом, отношение к технологиям искусственного интеллекта и их применении в принятии решений в различных прикладных областях вызывает неоднозначную реакцию у участников исследования. В некоторых исследованиях указывается, что чем выше уровень веры в возможности ИИ и его позитивное влияние на общество, тем больше декларируется страх порабощения человечества машинами [Нестик, 2018]. Так и в нашем исследовании многие причины доверия и недоверия могут совпадать или трактоваться как в положительную, так и в отрицательную сторону. В ходе бесед с респондентами некоторые из них сами упоминали о том, что не могут точно определить свое отношение к данной технологии. Как правило, восхищение технологией, ее прикладными возможностями у тех же респондентов сочеталось со страхами внедрения технологии. Эти страхи, в основном, были связаны с людьми, которые будут применять данную технологию, страхами отсутствия возможности отказаться от решения технологии, отсутствием достаточной глубины знаний в области технологии.

Важно отметить, что отношение к одной и той же технологии на разных уровнях ее автоматизации может вызывать у одних и тех же людей абсолютно разные уровни доверия. Например, проверка здоровья искусственным интеллектом могла вызывать интерес, в то же время респондент высказывал желание, чтобы окончательный диагноз ему ставил человек.

Другой сквозной темой обсуждения была интуиция в контексте принятия решений. Респонденты описывали ее и как преимущество в принятии решения человеком, которым не обладает ИИ. Возможно, это попытка разграничить, каким образом решение принимается человеком и ИИ.

Говоря о специфике принятия именно экономических решений с участием ИИ основная гипотеза исследования подтверждается на качественном уровне. Респонденты обозначили важность факторов времени и эксклюзивности решения, влияющих на то, можно ли доверять ИИ в случае экономического решения, спонтанно рассуждали об амбивалентности отношения к ИИ на разных уровнях автоматизации. Такие результаты качественного этапа дают возможность предполагать наличие различий в уровнях доверия ИИ в случае принятии конкретного экономического решения. В какую сторону и каким образом — мы сможем рассмотреть ниже в эксперименте.

Второй этап (эксперимент)

Целью второго этапа была проверка наличия зависимости уровня доверия совету от того, является советник человеком или ИИ.

Как упоминалось в разделе «Методы исследования», перед основным сбором экспериментальных данных был проведен пилот экономической игры. Были собраны данные в рамках гипотез, связанных с интерпретацией участниками своих действий в игре.

Во-первых, удалось операционализировать понятие доверия в рамках нашего эксперимента.

Участники исследования спонтанно комментировали следование рекомендациям следующим образом: «Слушай, ну ему лучше знать, чем мне, у него опыта никакого, лучше я ему доверюсь и на каждом ходу буду делать, как он говорит».

В то же время просто обращение за помощью к онлайн-советнику в игре не интерпретируется как доверие ему. Поэтому в ходе анализа мы брали данные по тем, кто не просто обратился к помощнику, но еще и последовал его совету. Участники часто обращались к онлайн-советнику просто из любопытства, некоторые просто забывали о нем в ходе игры: «Я обращался каждый раз, а почему нет, интересно, будет он угадывать или нет»; «Обращался? Да, но не следовал его советам, всегда сам все равно решение принимал»; «Ой, я вообще про него забыла, если честно».

Участники поясняли свое обращение за советом в таком случае как подтверждение уже принятого ими решения: «Я свое решение уже приняла, сейчас посмотрим, что он мне...»; «Я использовал его скорее для подтверждения своего решения...»; «О, получается, он тоже думает, надо продавать, тогда можно даже побольше продать».

В рамках пилота удалось понять, что уровень доверия онлайн-помощнику интерпретируется участниками как сумма денег, которую они готовы ввести в игру, исходя из его рекомендаций (в рамках данной работы мы называем это экономической активностью/ход), чем больше эта сумма денег, тем доверие выше: «Ну вот в прошлый раз он меня не подвёл, можно и побольше акций в этот раз купить…»; «Так ну раз у него 8 из 10 правильно и два раза он уже облажался, то теперь не должен, думаю, ему можно доверять, можно все-таки продавать, как он говорит».

Данное восприятие доверия вполне закономерно. Во многих работах, посвященных роли доверия в экономической активности населения, демонстрируют связь социального доверия и желания платить налоги [например: 14; 15].

Обработка данных проходила с помощью программы IBM SPSS 24.

Для выявления значимых различий между группами использовался критерий Т-Стьюдента для независимых выборок. Всего было собрано 800 экономических решений.

В ходе проведения статистического анализа первоначальных гипотез были использованы суммарные данные по участникам .

Основная гипотеза подтверждена, обнаружены значимые различия на уровне значимости t= 3,646; p<0,001. В данной гипотезе было проанализировано 258 экономических решений (были отобраны только те, где происходило обращение к помощнику и выполнено действие, посоветованное помощником, см. Таблица 1).

Таблица 1

Описательные статистики по экономической активности в экспериментальной и контрольной группах (N = 258)

|

Советник |

N |

Среднее |

Станд. отклонения |

Станд. средняя ошибка |

|

Человек |

139 |

,2726 |

,23581 |

,02000 |

|

ИИ |

119 |

,1820 |

,16077 |

,01474 |

Таблица 2

Критерий для независимых выборок для гипотезы исследования

|

|

Критерий равенства дисперсий Ливиня |

t-критерий для равенства средних |

||||

|

Экономическая активность |

Предполагаются равные дисперсии |

9,776 |

,002 |

3,543** |

256 |

,000 |

|

Не предполагаются равные дисперсии |

|

|

3,646** |

244,307 |

,000 |

|

Примечание. ** — обнаруженные различия значимы на уровне <0.001.

Полученные результаты говорят о различии в уровнях экономической активности в ходах, где участники не просто обращались за подсказкой советника, но именно выполняли после этой подсказки действие, предписываемое подсказкой (см. Таблица 2). Причем если мы обратимся к средним значениям экономической активности, то увидим, что среднее показание экономической активности в группе с советником-человеком заметно выше (среднее — человек = 0,2726 против среднее — ИИ = 0,1820 соответственно).

Возможным объяснением может служить факт проявления доверия помощнику через экономическую активность участников. Данное предположение основано на результатах пилота, где участники интерпретировали доверие помощнику через то количество денег, которые они готовы задействовать в игре по его совету. Мы также должны отметить фактор неопределенности в ситуации принятия экономического решения в игре. Этот фактор может быть определяющим для конструирования представлений об абстрактном объекте, на основе которых будет строиться дальнейшее доверие [Bierhoff, 2004].

Говоря о сравнении средних в показателях экономической активности у двух групп, вспоминаются результаты первой части исследования относительно доверия ИИ в принятии экономических решений. Респонденты выделяли два основных фактора, которые оказывали влияние на уровень этого доверия: индивидуальность советов и скорость необходимого решения. Здесь участникам нужно было принимать быстрые решения, а советы и сама игра носили индивидуальный характер, что могло повлиять на доверие ИИ. В то же время специфика механизма игры — акции также может оказывать влияние, несмотря на то, что в выборке мы ввели критерий опыта в купле — продаже акций. Акции позиционируются как экономическое решение с долей неопределенности. То есть невозможно досконально просчитать, куда пойдет акция дальше — есть вероятность резкого изменения динамики. Таким образом, случай купли — продажи акций может быть похож на ситуацию, где важна интуиция, присущая только человеку.

Выводы

- Уровень доверия советам в экономическом решении может быть выражен в виде экономической активности (выражается в готовности тратить большую или меньшую сумму денег за ход). Респонденты в ходе пилотной проверки экономической игры комментировали свои действия и транслировали готовность тратить больше денег в случае, если доверяют рекомендации советника, которую они выполняют в данный ход.

- Уровень доверия экономической рекомендации зависит от того, дает рекомендацию человек или ИИ. Данная закономерность была выявлена на втором этапе в ходе пилота экономической игры. Получены значимые различия между контрольной и экспериментальной группой среди тех, кто следовал рекомендациям своего советника.

- На уровень доверия ИИ в экономическом решении могут влиять как факторы доверия ИИ в общем, так и факторы, специфические для экономической сферы — индивидуальность решения и скорость, с которой необходимо принять решение.

- Уровень доверия технологии может отличаться в зависимости от уровня автоматизации системы, областей ее применения, уровня контроля человека за принятием окончательного решения, а также на доверие могут оказывать влияние такие личностные характеристики, как технофобия, групповые нормы и ценности, мнение значимых близких. Также уровень декларируемого доверия может быть связан с типом задачи, которую необходимо решить — быстрые решения, требующие оперативности в обработке данных, респонденты склонны доверять искусственному интеллекту.

Ограничения. Среди возможных причин подобного результата можно также рассматривать и личностные особенности участников. Они могли оказать влияние на их экономическую активность при использовании подсказок советника-ИИ или советника-человека. Мы не можем исключать влияния личностного фактора, так как не была проведена предварительная оценка личностных факторов, влияющих на отношение к технологии ИИ. В данной работе мы делаем фокус на выборке неспециалистов, как в финансовой области, так и ИТ. Предполагается, что рассмотрение данных выборок могло бы дать результаты, отличные от полученных.

Экономические решения, на основе которых делаются выводы данного исследования, были игровыми, не включали использование реальных денег. Такая особенность, несмотря на большую включенность участников во время игры, могла оказать серьезное влияние на свободу в использовании средств.

Литература

- Андреева Г.М. и др. Социальная психология. М.: Аспект Пресс, 2001. Т. 2.

- Гозман Л.Я. Психология эмоциональных отношений. М.: Изд-во Моск. ун-та, 1987. 175 с.

- Журавлев А.Л., Нестик Т.А. Социально-психологические последствия внедрения новых технологий: перспективные направления исследований // Психологический журнал. 2019. Том 40. № 5. С. 35—47.

- Купрейченко А.Б. Доверие и недоверие технике и социотехническим системам: постановка проблемы и обоснование подхода к исследованию // Ученые записки ИМЭИ. 2012. Том 2. № 1. С. 126—137.

- Купрейченко А.Б. Психология доверия и недоверия. М.: Изд‑во «Институт психологии РАН», 2008. 564 с.

- Нестик Т.А. Социально-психологические предикторы отношения личности к новым технологиям // Информационное общество: образование, наука, культура и технологии будущего. 2018. № 2. С. 309—319.

- Сафонов В.С. О психологии доверительного общения // Проблема. общения в психологии / Отв. ред. Б.Ф. Ломов. М., 1981. С. 264—272.

- Скрипкина Т.П. Психология доверия. Учеб. пособие для студ. высш. пед. учеб. заведений. М.: Академия, 2000. 264 с.

- Солдатова Г.У., Нестик Т.А. Отношение к интернету среди интернет-пользователей: технофобы и технофилы // Вестник Московского государственного областного университета. Серия: Психологические науки. 2016. № 1. С. 54—61.

- Bickmore T., Cassell J. Social dialongue with embodied conversational agents //Advances in natural multimodal dialogue systems. Springer, Dordrecht, 2005. P. 23—54.

- Bierhoff H.W., Vornefeld B. The social psychology of trust with applications in the internet // Analyse & Kritik. 2004. Vol. 26. № 1. P. 48—62.

- Castelfranchi C. Modelling social action for AI agents // Artificial intelligence. 1998. Vol. 103. № 1—2. P. 157—182.

- Fridman L., et al. Mit autonomous vehicle technology study: Large-scale deep learning based analysis of driver behavior and interaction with automation. arXiv preprint arXiv:1711.06976. 2017. Vol. 1. Preprint at: https://arxiv.org/abs/1606.05718

- Habibov N., Cheung A., Auchynnikava A. Does social trust increase willingness to pay taxes to improve public healthcare? Cross-sectional cross-country instrumental variable analysis // Social Science & Medicine. 2017. Vol. 189. P. 25—34.

- Habibov N., Cheung A., Auchynnikava A. Does trust increase willingness to pay higher taxes to help the needy? // International Social Security Review. 2017. Vol. 70. № 3. P. 3—30.

- Jarrahi M.H. Artificial intelligence and the future of work: Human-AI symbiosis in organizational decision making // Business Horizons. 2018. Vol. 61. № 4. P. 577—586.

- Longoni C., Bonezzi A., Morewedge C.K. Resistance to medical artificial intelligence // Journal of Consumer Research. 2019. Vol. 46. № 4. P. 629—650.

- Lucas G.M., et al. It’s only a computer: Virtual humans increase willingness to disclose // Computers in Human Behavior. 2014. Vol. 37. P. 94—100.

- Marwala T. Artificial intelligence techniques for rational decision making // Springer International Publishing 2014. 168 p.

- Ulfert A.S., Antoni C.H., Ellwart T. The role of agent autonomy in using decision support systems at work, Computers in Human Behavior, 2022, Vol. 126. P. 106987.

- Wang, Dayong, et al. Deep learning for identifying metastatic breast cancer // arXiv preprint arXiv:1606.05718. 2016. Preprint at: https://arxiv.org/abs/1606.05718

- Yu T.K., Lin M.L., Liao Y.K. Understanding factors influencing information communication technology adoption behavior: The moderators of information literacy and digital skills. Computers in Human Behavior, 2017. Vol. 71. P. 196—208.

- Zhang Q., Lee M.L., Carter S. You complete me: Human-ai teams and complementary expertise. Proceedings of the 2022 CHI Conference on Human Factors in Computing Systems, 2022. P. 1—28.

Информация об авторах

Метрики

Просмотров

Всего: 1031

В прошлом месяце: 52

В текущем месяце: 47

Скачиваний

Всего: 380

В прошлом месяце: 19

В текущем месяце: 19